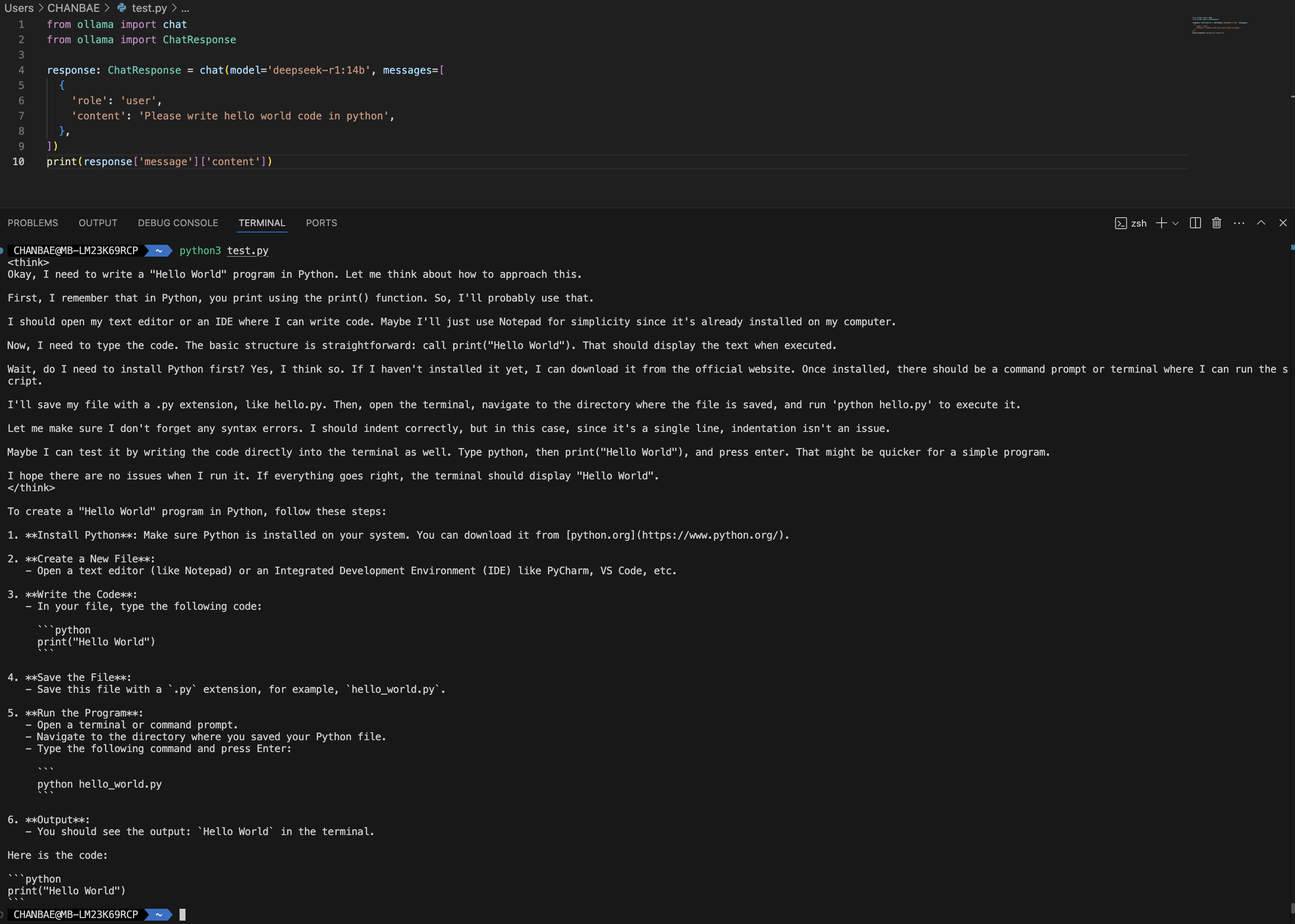

앞에 여러 글들에서 DeepSeek 사용 후기, Ollama를 이용하여 DeepSeek를 로컬 PC에서 돌리는 방법, DeepSeek를 로컬 PC에서 webUI와 연동하는 방법, DeepSeek를 이용하여 코딩하는데 도움을 받는 방법 #1, #2 등의 글을 썼다. 여기서는 Ollama 파이썬 API 를 이용하여 DeepSeek(딥시크) R1을 코딩에 사용하는 방법에 대해서 알아본다. Ollama는 오픈소스 LLM을 사용하는 서비스이기 때문에 DeepSeek R1뿐만 아니라 Ollama에서 지원하는 다양한 LLM 모델 (메타의 llama, qwen2.5 등)을 간단한 환경설정 변경으로 동일한 코드와 API로 사용할 수 있다. 설치 방법 pip 또는 pip3 명령어로 ollama python 모듈을 설치한다..