Visual Studio Code (VS Code)에서 DeepSeek (딥시크)를 사용하는 방법을 간단히 이야기해보려고 한다. VS Code Extension 설치해서 간단한 Configuration을 하면 쉽게 사용이 가능하다.

여기서 사용할 Extension은 Continue 이고 간단한 설치와 설정으로 DeepSeek를 사용할 수 있게 해준다. 이 Extension을 선택한 이유는 이전의 블로그 글에서 이야기한 local PC에서 쉽게 돌릴 수 있는 서비스인 ollama 를 지원하고 많은 개발자들이 사용, 업데이트도 잘되기 때문이다.

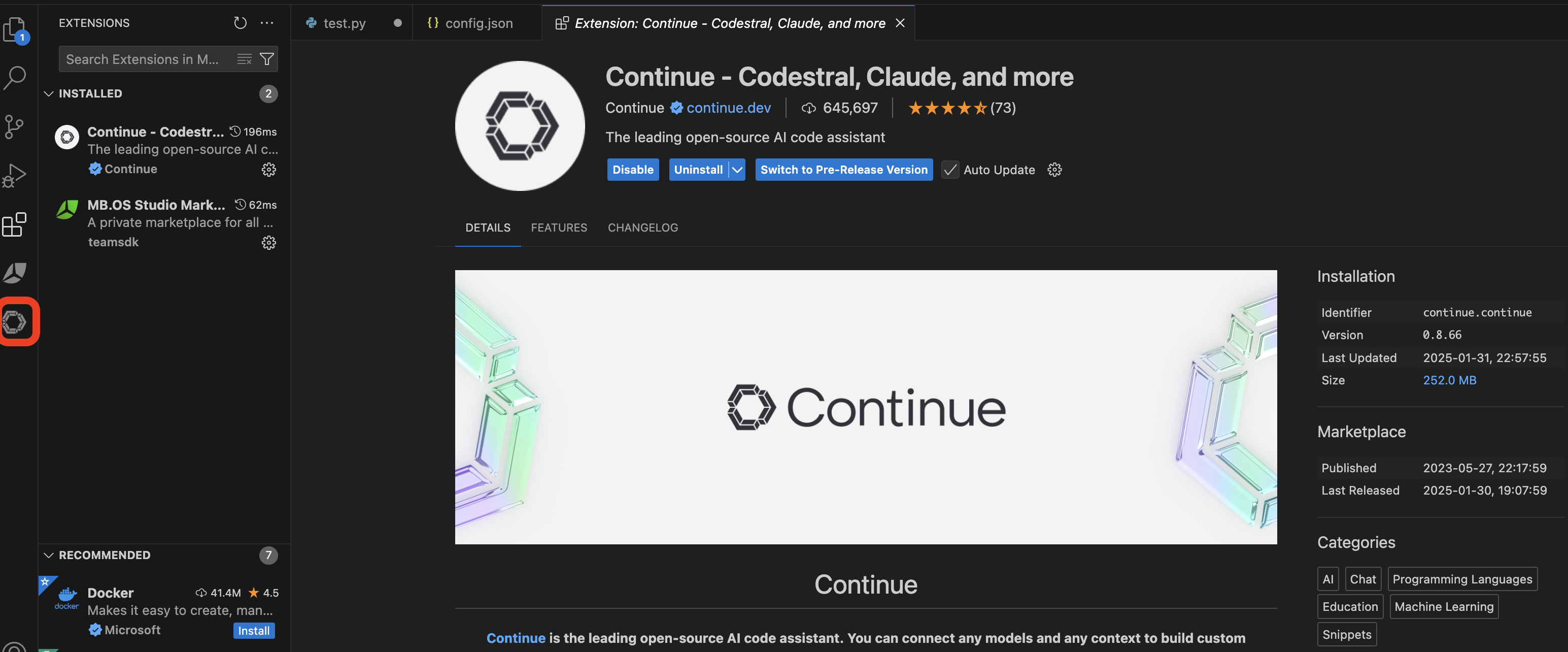

Extension 설치

우선 VS Code를 실행하고 Extensions에서 Continue를 검색한 후 Install 버튼을 눌러 설치한다.

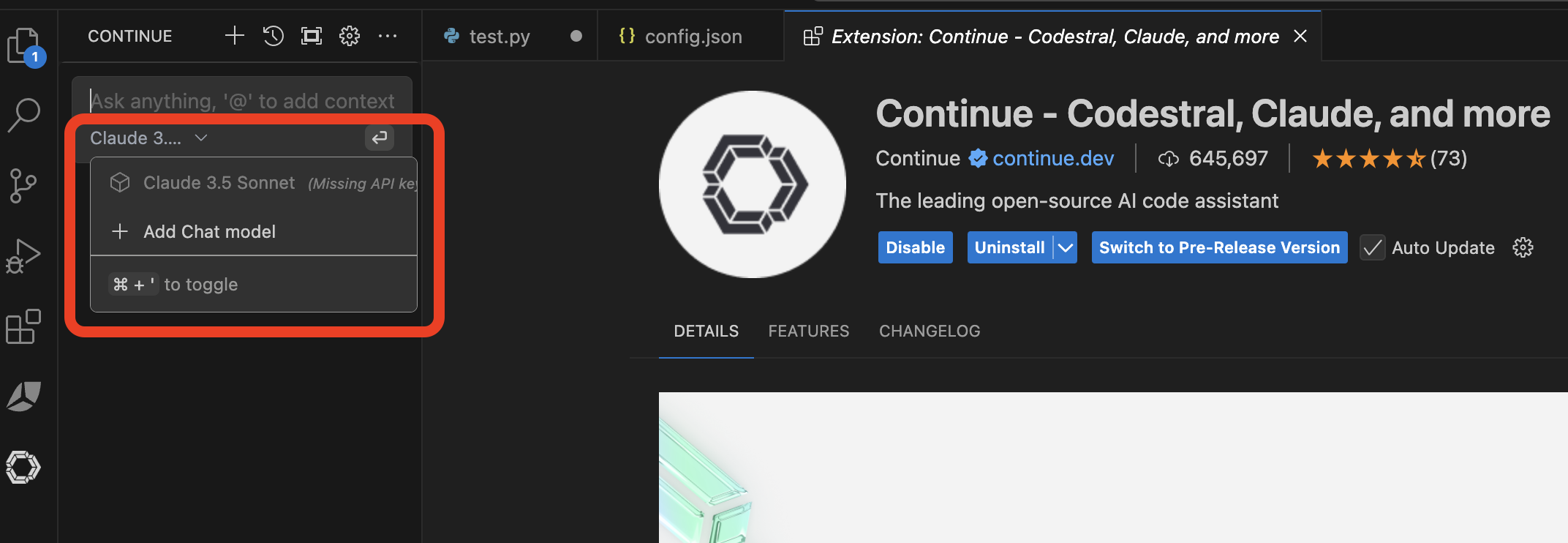

설치가 완료되면 위의 그림과 같이 왼쪽 제일 아래 Continue 로고가 생성되고, 그 로고를 클릭하면 EXTENSIONS이 나온 창이 아래와 같은 화면으로 전환된다.

CONTINUE Extension 설정

Continue 창에서 Claude 3... 옆에 있는 ᐯ 를 클릭하여 Add Chat model 을 선택한다.

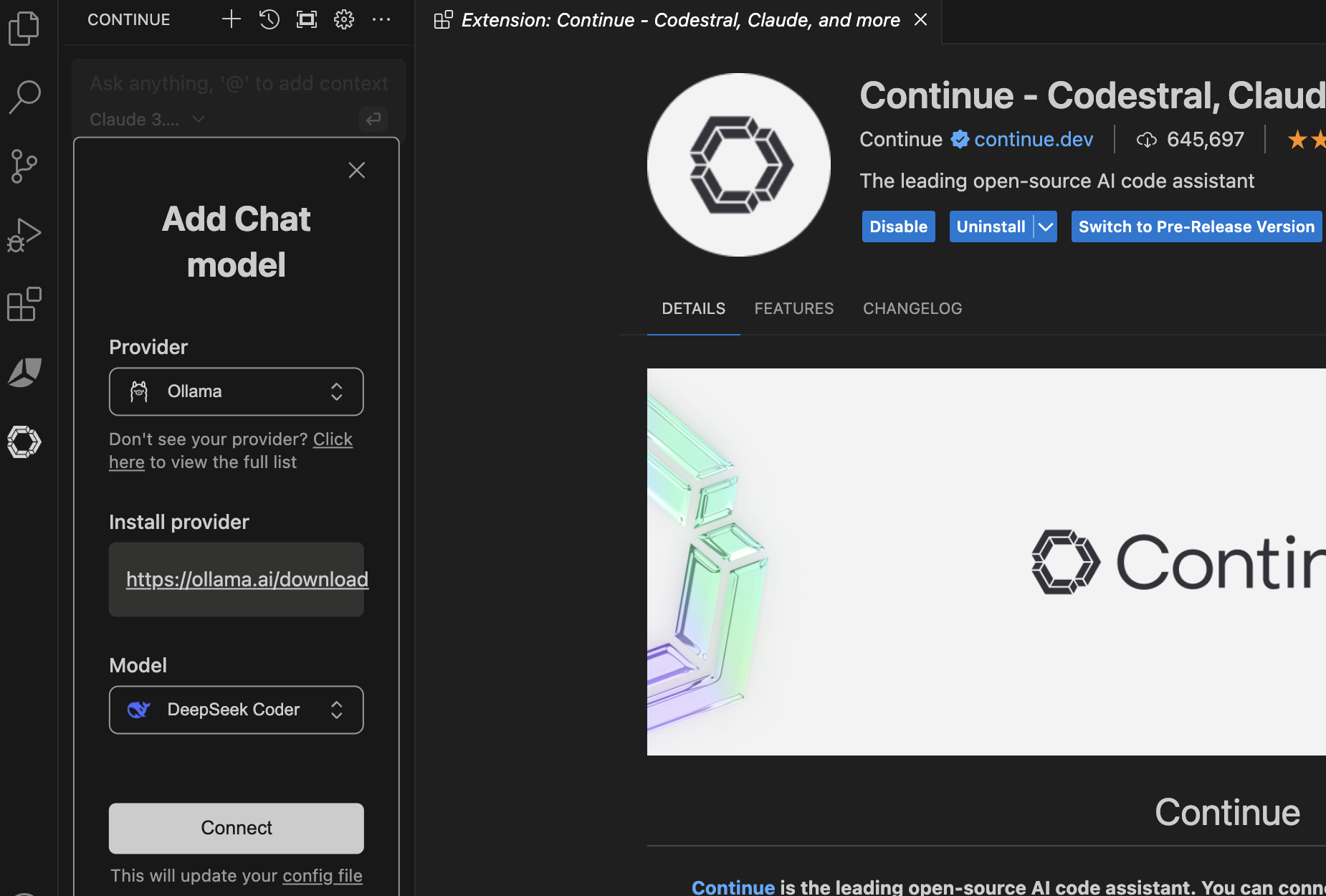

아래와 같은 화면이 나오면 Provider에서는 Ollama를, Model은 원하는 모델을 선택한다. 여기서는 Model에서 DeepSeek Coder을 선택해보기로 한다.

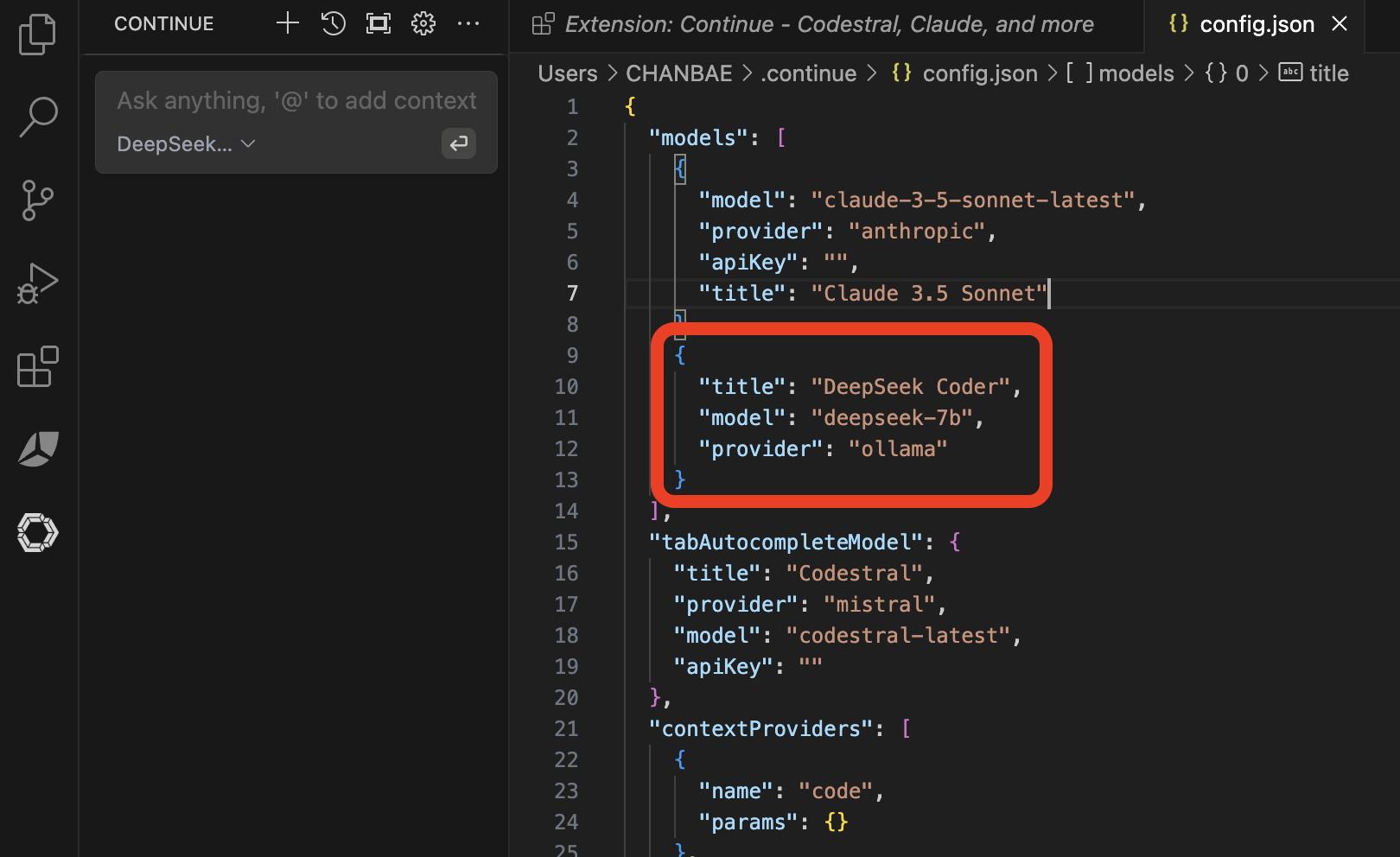

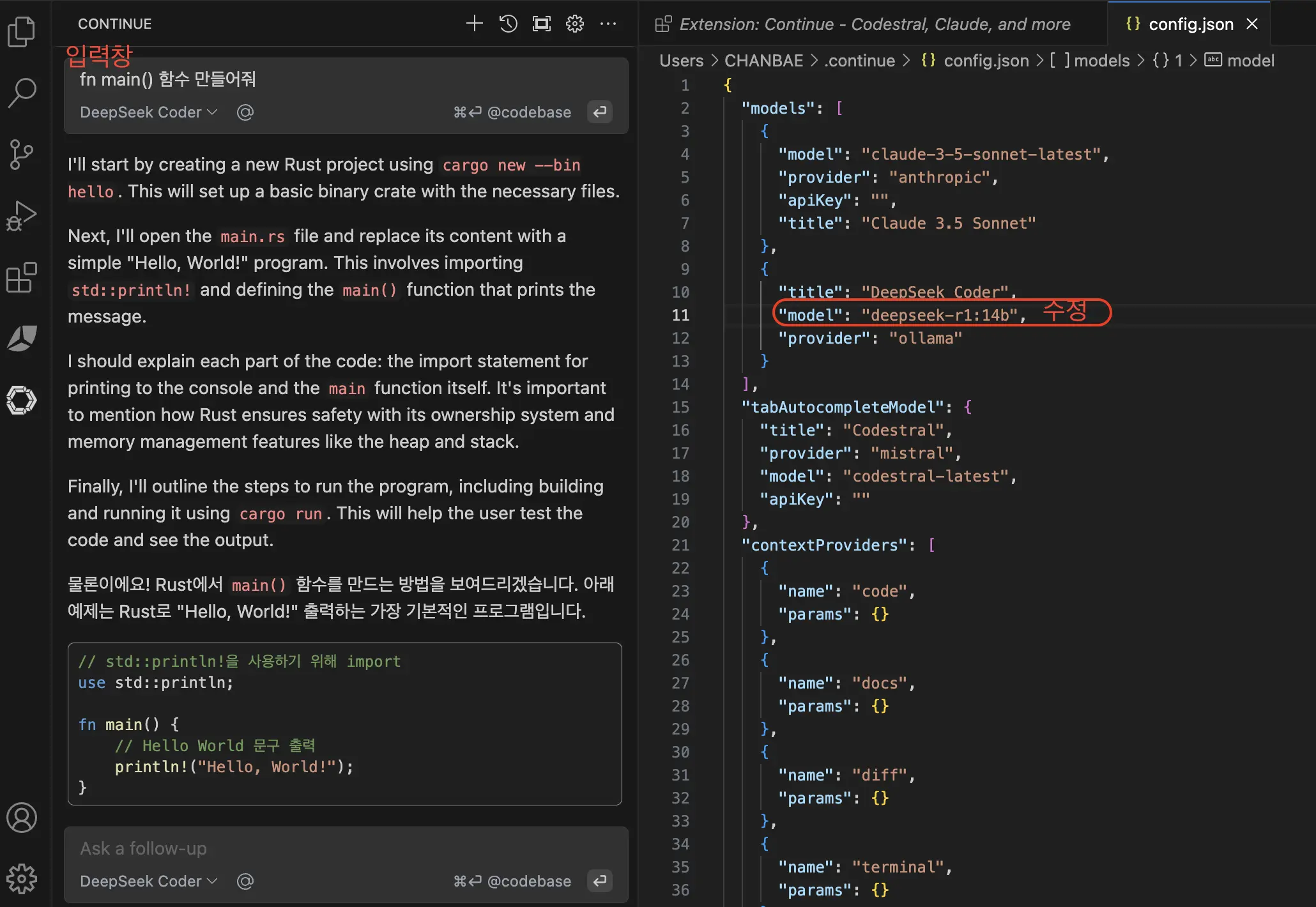

Connect 을 누르고 넘어가면 화면이 다음과 같이 전환이 되며, 오른쪽 창에는 config.json 파일이 열리게 된다.

주의) 터미널에서 "ollama serve" 명령어를 미리 실행시켜 놓아야 한다. 또한 "ollama list" 명령어를 통해 현재 내 PC에 설치되어 있는 모델의 이름을 확인하고 아래 그림에 빨간 박스 내에 있는 model 이름과 일치하는지 확인한다. 그렇지 않으면 model이 없다고 실제 실행할 때 에러가 난다. 기본은 deepseek-7b으로 되어 있지만 그 모델과 PC에 설치된 모델 이름이 달라서 deepseek-r1:14b로 변경하고 저장했다.

테스트

아래와 같이 입력창에 코드나 질문을 입력하고 Macbook이면 아래서 지시한대로 Command 키와 Enter 키를 동시에 누르면 ollama가 deepseek (딥시크) r1:14b를 이용하여 해석한 후 결과를 바로 보여준다.

정리

과정을 진행하면서 화면을 캡쳐하고 글을 길게 썼는데, VS Code에 Continue Extension을 설치하고 ollama를 통해 설치된 모델을 선택한 후 사용하는 것으로 간단히 정리가 된다.

deepseek-r1 7b, 14b, 32b 각각 써봤는데 역시나 7b는 성능이 너무 떨어져서 가급적이면 실제 사용하는데는 추천하지 않는다. 지금 글에서는 Extension 창에서 사용하는 것을 보여주었는데 Copilot 에서 사용했던 것 처럼 실제 코드에서 단축키와 연결하여 사용하는 방법을 찾아서 해보고 다음 글을 남길 예정이다.

처음 해보는 독자들이 가능하면 쉽게 따라해볼 수 있도록 정리하려고 노력했다. 그리고 하면서 불편한 부분도 하나씩 개선해보려고 한다. Local PC에서 LLM 오픈소스 모델을 돌리는 것에 대한 장점은 다들 우려하는 정보가 외부로 유출되지 않는다는 점이다. 반면에 Local 설정이 필요하고 LLM 모델과 개발자의 PC의 사양 따라서 성능이 안따라주고 돌리기 어려울 수도 있다.

기존에도 많은 오픈소스 LLM 모델이 나왔지만 deepseek (딥시크)가 이번에 워낙 핫한 모델이다 보니 덕분에 이렇게 해볼 수 있는 기회가 생긴 것 같다. deepseek에 대한 논란이 많지만 그만큼 뛰어난 성능을 바탕으로 오픈 생태계에 기여하는 입장에서는 누구도 반론을 제기하지 않을 것 같다.

'Development' 카테고리의 다른 글

| VS Code에서 DeepSeek (딥시크) 사용 2 - 코드와 인터랙션 (0) | 2025.02.03 |

|---|---|

| DeepSeek (딥시크)를 PC에서 web UI와 연동 (0) | 2025.01.31 |

| ollama를 사용하여 DeepSeek (딥시크) R1를 내 PC에서 실행 (0) | 2025.01.30 |

| DeepSeek (딥시크) 사용 후기 (2) | 2025.01.28 |

| Intel Ultra 9 185H (22 Threads) CPU 노트북 사용 후기 (2) | 2024.12.18 |