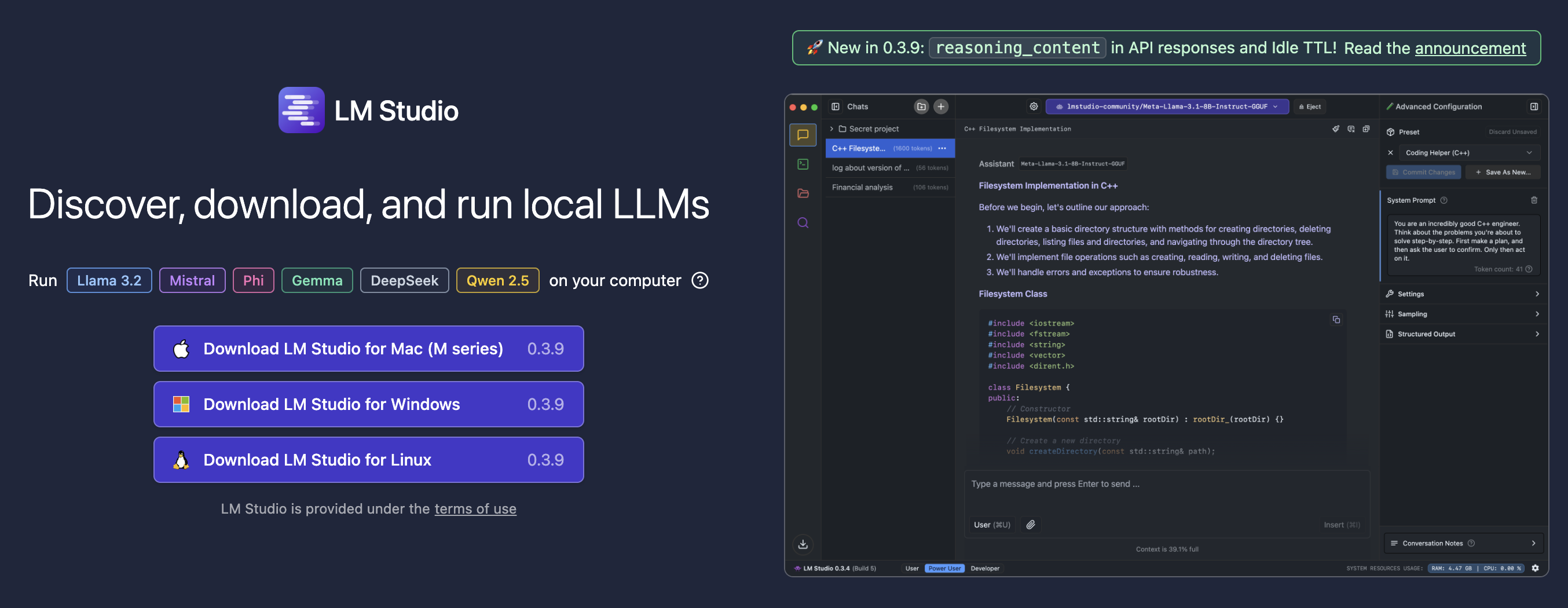

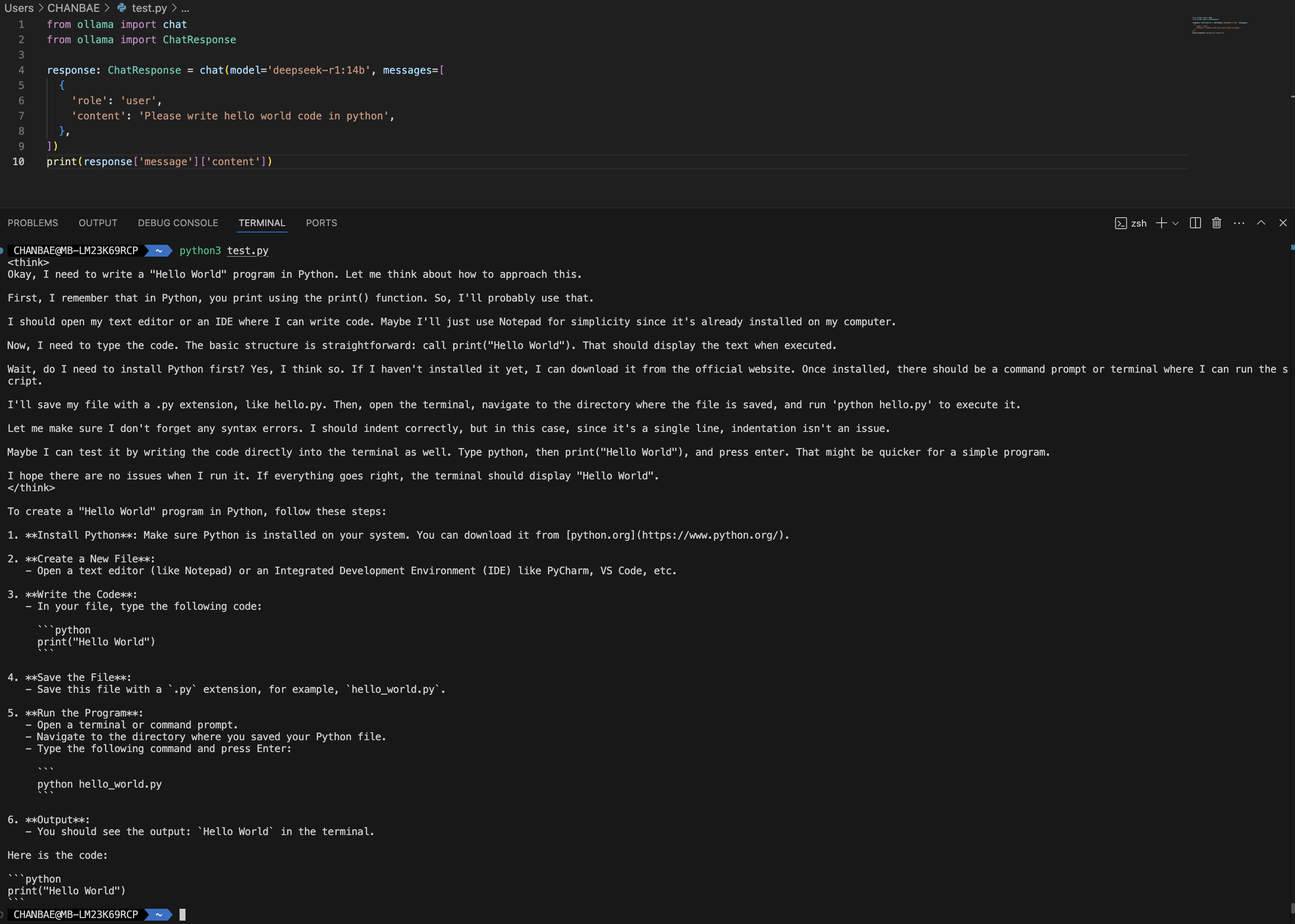

이전 블로그 글에서 command line 으로 deepseek (딥시크)와 같은 오픈 LLM 모델을 설치하여 돌라는 방법을 이야기하였다. UI 를 기본적으로 제공하지 않기 때문에 Chromium Extension을 설치하여 사용하는 방법에 대해서도 이야기하였다. LM Studio 소개 이를 모두 하나로 통합하여 제공하는 LM Studio를 발견하여 설치하고 사용하는 방법에 대해서 소개한다. LM Studio도 애플 실리콘, Windows, Linux 모두 지원을 한다. 맥북에서 돌리기 위해 받았는데 1.41GB로 생각보다 애플리케이션의 크기가 컸다. LM Studio 기능 LM Studio로 다음과 같은 것을 할 수 있다고 홈페이지 메인에 당당하게 적혀있다. 앱만 설치하면 정말 사용하기는 쉽게 되어있다..